Les applications mobiles d’entreprise suisses traitent quotidiennement des millions de transactions financières sensibles, nécessitant une infrastructure backend capable de garantir sécurité, scalabilité et résilience. Dans un écosystème où les standards bancaires suisses imposent des exigences parmi les plus strictes au monde, l’architecture traditionnelle monolithique montre rapidement ses limites face aux besoins croissants de performance et de conformité. Une interruption de service de quelques minutes peut coûter des millions de francs suisses et compromettre la confiance des clients dans des secteurs aussi sensibles que la banque, l’assurance ou la santé.

L’architecture microservices émerge comme la solution privilégiée pour répondre à ces défis complexes. Cette approche permet de décomposer les applications en services indépendants, chacun gérant une fonctionnalité métier spécifique et pouvant évoluer de manière autonome. Pour les entreprises suisses confrontées à l’intégration de systèmes legacy tout en respectant les normes FINMA et les standards de protection des données, cette architecture offre la flexibilité nécessaire sans compromettre la sécurité. L’orchestration via Kubernetes, combinée à un API Gateway robuste et un service mesh sophistiqué, crée un écosystème où la haute disponibilité devient la norme plutôt que l’exception.

Les enjeux dépassent la simple question technique pour toucher au cœur même de la compétitivité des entreprises suisses. Dans un marché où l’innovation digitale détermine la capacité à attirer et retenir les clients, l’agilité d’une architecture microservices permet de déployer de nouvelles fonctionnalités en quelques jours plutôt qu’en mois. La capacité à gérer des pics de charge imprévisibles, à assurer une continuité de service 24/7 et à maintenir la conformité réglementaire constitue désormais un avantage concurrentiel décisif. Les entreprises qui maîtrisent cette architecture bénéficient d’une réduction des coûts opérationnels, d’une amélioration de l’expérience utilisateur et d’une résilience accrue face aux incidents.

Pour transformer ces ambitions en réalité et mettre en œuvre une architecture microservices adaptée aux spécificités suisses, un accompagnement expert s’avère indispensable. Découvrez comment notre expertise en développement d’applications mobiles Suisse peut vous aider à construire un backend sophistiqué respectant les standards les plus exigeants tout en optimisant vos coûts et délais de mise sur le marché.

Fondamentaux de l’architecture microservices pour applications mobiles suisses

Principes de décomposition en services autonomes

L’architecture microservices repose sur la décomposition d’une application en services indépendants, chacun possédant sa propre base de données et sa logique métier spécifique. Cette approche contraste radicalement avec les architectures monolithiques où toutes les fonctionnalités partagent la même base de code et la même infrastructure. Pour une application bancaire suisse, cela signifie séparer les services de gestion de compte, de paiement, d’authentification et de notification en entités distinctes communiquant via des API bien définies. Chaque microservice peut être développé avec la technologie la plus appropriée à sa fonction, permettant d’utiliser des langages et frameworks différents au sein d’une même application.

La définition des frontières entre services constitue un exercice stratégique crucial pour le succès d’une architecture microservices. Les bonnes pratiques recommandent de suivre le principe du Domain-Driven Design, en alignant chaque service sur un contexte métier délimité. Dans le contexte suisse, où les exigences réglementaires varient selon les cantons et les secteurs, cette granularité permet d’isoler les règles spécifiques dans des services dédiés facilitant la maintenance et la conformité. Un service doit être suffisamment autonome pour être déployé indépendamment, mais assez cohérent pour représenter une fonctionnalité métier complète sans dépendances excessives vers d’autres services.

L’autonomie des équipes constitue l’un des bénéfices majeurs de cette approche architecturale. Chaque service peut être géré par une équipe dédiée possédant la responsabilité complète du cycle de vie, du développement au déploiement en production. Cette organisation favorise l’innovation et accélère les cycles de développement, puisque les équipes n’ont pas besoin de coordonner chaque modification avec l’ensemble de l’organisation. Pour les entreprises suisses opérant dans plusieurs langues, cette structure permet également d’affecter des équipes spécialisées sur des services régionaux tout en maintenant la cohérence globale de l’application mobile.

Patterns de communication et gestion événementielle

Les microservices communiquent principalement via deux modèles : la communication synchrone basée sur des API REST ou gRPC, et la communication asynchrone utilisant des systèmes de messagerie événementielle. La communication synchrone convient aux opérations nécessitant une réponse immédiate, comme la validation d’un paiement ou la vérification d’un solde de compte. Les protocoles REST avec JSON restent dominants pour leur simplicité et leur interopérabilité, tandis que gRPC gagne en popularité pour les communications internes grâce à sa performance supérieure et son typage strict via Protocol Buffers. Le choix entre ces approches dépend des contraintes de latence, du volume de données échangées et des compétences techniques disponibles.

L’architecture événementielle (event-driven) représente le paradigme optimal pour les applications d’entreprise suisses nécessitant haute scalabilité et découplage maximal. Dans ce modèle, les services publient des événements dans un bus de messages lorsqu’un changement d’état significatif survient, et d’autres services s’abonnent à ces événements pour réagir en conséquence. Des solutions open source comme Apache Kafka ou RabbitMQ permettent d’implémenter cette architecture avec des garanties de livraison et une persistance des messages. Pour une application de trading financier, cette approche permet de propager instantanément les fluctuations de cours à tous les services concernés sans couplage direct, assurant ainsi une cohérence éventuelle tout en maintenant la réactivité.

Le pattern CQRS (Command Query Responsibility Segregation) combiné à l’event sourcing constitue une approche avancée particulièrement adaptée aux exigences de traçabilité des entreprises suisses. Cette architecture sépare les opérations d’écriture (commandes) des opérations de lecture (requêtes), utilisant des modèles de données optimisés pour chaque usage. L’event sourcing persiste non pas l’état actuel mais l’intégralité des événements ayant conduit à cet état, créant ainsi un journal d’audit immuable indispensable pour les applications financières soumises aux régulations FINMA. Cette approche facilite également la reconstruction de l’état à n’importe quel moment et permet d’analyser rétroactivement le comportement du système.

Stratégies de gestion des bases de données distribuées

Le principe fondamental des microservices stipule que chaque service possède sa propre base de données, évitant ainsi le couplage par le partage de schémas. Cette approche garantit l’autonomie et permet à chaque équipe de choisir la technologie de stockage la plus adaptée à ses besoins spécifiques : bases relationnelles pour les données transactionnelles, bases NoSQL pour les catalogues de produits, bases de séries temporelles pour les métriques, ou bases en mémoire pour le caching. Pour une application d’assurance suisse, le service de gestion des contrats peut utiliser PostgreSQL pour garantir l’intégrité relationnelle, tandis que le service de recommandation exploite MongoDB pour sa flexibilité de modélisation et sa performance en lecture.

La cohérence des données dans un environnement distribué représente l’un des défis architecturaux les plus complexes. Le théorème CAP démontre qu’un système distribué ne peut garantir simultanément cohérence absolue, disponibilité totale et tolérance au partitionnement réseau. Les architectures microservices privilégient généralement la cohérence éventuelle, acceptant qu’une modification puisse prendre quelques millisecondes ou secondes pour se propager à tous les services concernés. Cette approche nécessite une conception soigneuse des processus métier pour identifier les opérations pouvant tolérer cette latence et celles nécessitant une cohérence transactionnelle forte, qui peuvent alors être regroupées au sein d’un même service.

Le pattern Saga constitue la solution recommandée pour orchestrer les transactions distribuées sans recourir aux transactions ACID traditionnelles impossibles dans un contexte microservices. Une saga décompose une transaction métier longue en une séquence d’opérations locales, chacune suivie de la publication d’un événement déclenchant l’étape suivante. En cas d’échec à n’importe quelle étape, des transactions compensatoires annulent les modifications précédentes pour maintenir la cohérence métier. Pour un processus de souscription d’assurance impliquant vérification d’identité, évaluation des risques et génération du contrat, chaque étape s’exécute dans un service différent avec des compensations définies pour gérer les échecs à tout moment du parcours.

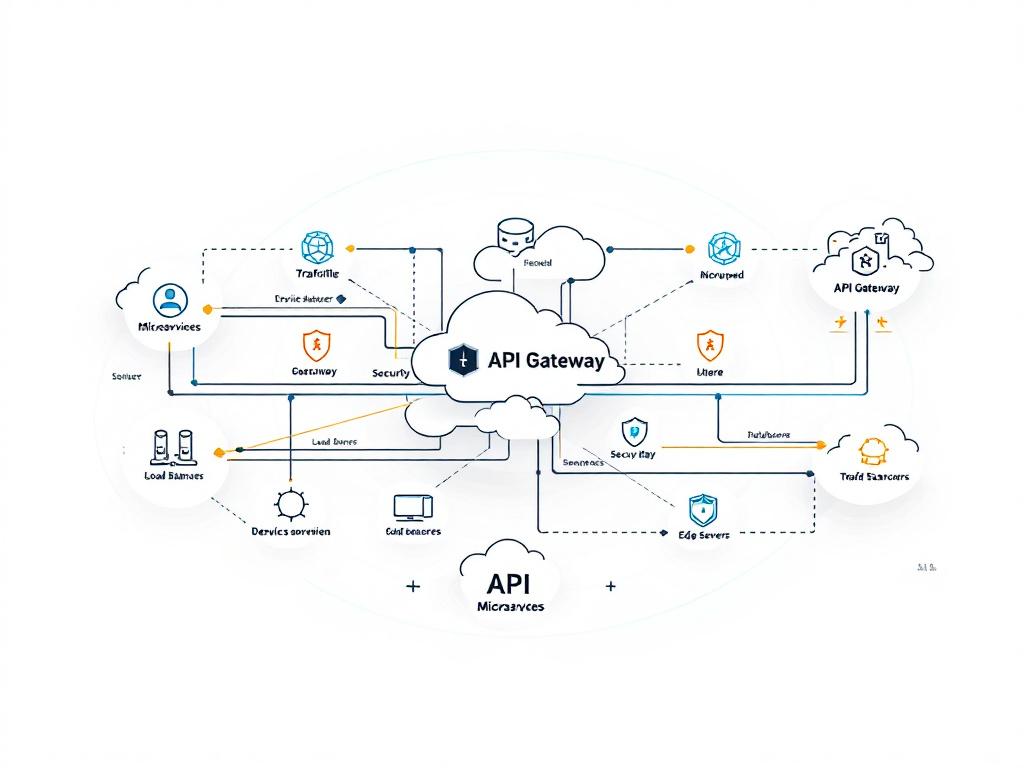

API Gateway et Service Mesh : orchestration et sécurisation du trafic

Rôle et fonctionnalités essentielles de l’API Gateway

L’API Gateway constitue le point d’entrée unique pour toutes les requêtes provenant des applications mobiles vers l’infrastructure backend microservices. Cette couche d’abstraction masque la complexité de l’architecture distribuée aux clients, qui interagissent avec une interface unifiée plutôt qu’avec des dizaines de services individuels. L’API Gateway assure des fonctions critiques incluant le routage intelligent des requêtes vers les services appropriés, l’agrégation de réponses provenant de multiples services en une seule réponse cohérente, et la transformation des protocoles pour adapter les communications internes aux besoins des clients mobiles. Pour les entreprises suisses, cette centralisation simplifie également l’application des politiques de sécurité et de conformité sur l’ensemble du trafic entrant.

Les fonctionnalités de sécurité de l’API Gateway revêtent une importance particulière dans le contexte des applications financières suisses. L’authentification et l’autorisation centralisées permettent de valider l’identité des utilisateurs et leurs permissions avant même que les requêtes n’atteignent les microservices métier. L’intégration avec des solutions d’identity management comme Keycloak ou des services OAuth2/OpenID Connect garantit une gestion robuste des sessions et des tokens JWT. Le rate limiting et le throttling protègent l’infrastructure contre les attaques par déni de service et les usages abusifs, en limitant le nombre de requêtes autorisées par client sur une période donnée. Ces mécanismes s’avèrent indispensables pour maintenir la qualité de service même lors de pics de trafic imprévus.

Des solutions open source comme Kong, Tyk ou Apache APISIX offrent des capacités d’API Gateway enterprise-grade sans les coûts de licences propriétaires. Kong, construit sur NGINX, se distingue par sa performance exceptionnelle et son écosystème de plugins couvrant l’authentification, le logging, la transformation de requêtes et l’analytics. Tyk propose une interface d’administration particulièrement intuitive et des capacités avancées de versionning d’API facilitant les migrations progressives. Apache APISIX, solution émergente de la Cloud Native Computing Foundation, offre un routage dynamique ultra-performant et une configuration en temps réel sans redémarrage. Le choix entre ces solutions dépend des compétences disponibles, des besoins spécifiques en termes de plugins et de la stratégie cloud de l’entreprise.

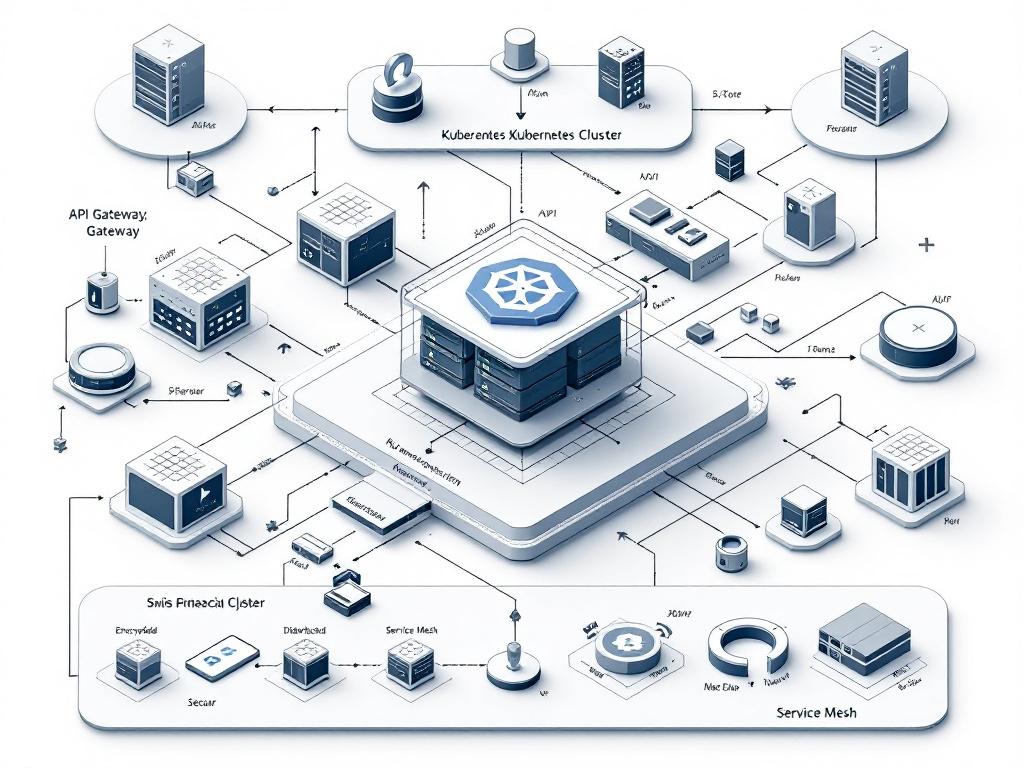

Architecture Service Mesh pour la communication inter-services

Le service mesh constitue une couche d’infrastructure dédiée à la gestion de la communication entre microservices, déchargeant les services applicatifs de ces préoccupations transversales. Contrairement à l’API Gateway qui gère le trafic nord-sud (entre clients et services), le service mesh contrôle le trafic est-ouest (entre services internes). L’architecture repose sur le déploiement d’un proxy léger (sidecar) à côté de chaque instance de microservice, interceptant toutes les communications entrantes et sortantes. Ces proxies forment ensemble un maillage (mesh) géré centralement via un plan de contrôle définissant les politiques de routage, de sécurité et d’observabilité. Pour les applications suisses à haute fréquentation, cette approche garantit une gestion cohérente du trafic sans modifier le code des services.

Istio s’impose comme la référence des solutions service mesh open source, offrant des fonctionnalités enterprise complètes dans un projet mature soutenu par Google, IBM et Lyft. Le plan de données d’Istio utilise Envoy Proxy, un proxy haute performance développé initialement par Lyft et devenu standard de l’industrie. Les capacités de traffic management d’Istio permettent des déploiements progressifs (canary deployments) où une nouvelle version d’un service ne reçoit initialement qu’un faible pourcentage du trafic, augmentant graduellement après validation. Le circuit breaking protège automatiquement l’infrastructure en isolant les services défaillants, évitant ainsi qu’une panne localisée ne se propage en cascade. La retry logic intelligente réessaie automatiquement les requêtes échouées avec des stratégies de backoff exponentiel.

La sécurité constitue l’apport majeur du service mesh pour les applications financières suisses soumises aux standards bancaires. Istio implémente automatiquement le chiffrement mTLS (mutual TLS) pour toutes les communications inter-services, garantissant confidentialité et authentification mutuelle sans nécessiter de modifications du code applicatif. Les politiques d’autorisation fine permettent de définir précisément quels services peuvent communiquer entre eux, appliquant le principe du moindre privilège au niveau réseau. L’intégration avec les systèmes de gestion d’identité externes assure la cohérence des politiques de sécurité entre le périmètre externe et les communications internes. Cette défense en profondeur répond aux exigences FINMA en matière de protection des données sensibles et de traçabilité des accès.

Observabilité et monitoring dans un environnement distribué

L’observabilité d’une architecture microservices repose sur trois piliers fondamentaux : les métriques, les logs et les traces distribuées. Les métriques quantitatives (CPU, mémoire, latence, taux d’erreur) fournissent une vision agrégée de la santé du système et permettent de détecter les anomalies. Les logs textuels capturent les événements détaillés survenant dans chaque service, facilitant le diagnostic des problèmes spécifiques. Les traces distribuées suivent le parcours complet d’une requête à travers tous les services impliqués, révélant les goulots d’étranglement et les dépendances critiques. La combinaison de ces trois dimensions offre la visibilité nécessaire pour opérer efficacement un système distribué complexe.

Prometheus et Grafana forment le duo standard pour le monitoring de clusters Kubernetes et d’architectures microservices. Prometheus collecte et stocke les métriques en séries temporelles, offrant un langage de requête puissant (PromQL) pour l’analyse et l’alerte. Son modèle pull où Prometheus interroge régulièrement les endpoints de métriques garantit la fiabilité et simplifie la configuration. Grafana visualise ces métriques dans des tableaux de bord personnalisables, permettant de corréler différentes sources de données et de créer des vues adaptées aux différentes équipes. Pour une application bancaire suisse, ces outils permettent de monitorer en temps réel le nombre de transactions, la latence moyenne par type d’opération, le taux d’erreur par service et la consommation de ressources, avec des alertes automatiques lorsque les seuils critiques sont franchis.

Le tracing distribué via Jaeger ou Zipkin apporte une dimension causale indispensable au diagnostic des problèmes de performance. Ces systèmes enregistrent le parcours complet de chaque requête, incluant tous les appels inter-services avec leurs durées respectives et leurs métadonnées contextuelles. L’analyse des traces révèle les services contribuant le plus à la latence totale, identifie les appels inutiles ou redondants, et détecte les problèmes de configuration réseau. L’intégration avec le service mesh automatise l’instrumentation, injectant automatiquement les headers de tracing sans modification du code applicatif. Pour une requête de consultation de solde traversant l’API Gateway, le service d’authentification, le service compte et le service historique, la trace visualise graphiquement cette chaîne d’appels avec les temps précis de chaque étape, facilitant l’optimisation ciblée des points faibles.

Scalabilité et résilience pour applications haute fréquentation

Orchestration et scaling automatique avec Kubernetes

Kubernetes s’est imposé comme la plateforme standard d’orchestration de conteneurs, offrant des capacités d’automatisation indispensables pour gérer des applications microservices à grande échelle. Cette plateforme open source gère le déploiement, la mise à l’échelle et l’exploitation de conteneurs applicatifs sur un cluster de machines physiques ou virtuelles. Kubernetes abstrait l’infrastructure sous-jacente, permettant aux développeurs de définir l’état souhaité de leur application via des manifestes déclaratifs, tandis que le système travaille continuellement pour maintenir cet état. Pour les entreprises suisses opérant des applications critiques, cette automatisation réduit drastiquement les risques d’erreurs humaines et garantit la cohérence des déploiements entre environnements de développement, test et production.

L’autoscaling horizontal constitue l’une des fonctionnalités clés de Kubernetes pour gérer les variations de charge. Le Horizontal Pod Autoscaler (HPA) surveille les métriques de performance comme l’utilisation CPU ou la mémoire, et ajuste automatiquement le nombre de répliques d’un service pour maintenir les cibles définies. Pour une application de e-banking suisse connaissant des pics de connexion en début et fin de journée, l’HPA augmente le nombre d’instances du service d’authentification durant ces périodes puis les réduit durant les heures creuses, optimisant ainsi les coûts d’infrastructure. Les métriques personnalisées permettent d’affiner ce scaling en fonction de paramètres métier comme le nombre de transactions en attente ou la longueur des files de messages.

Le Vertical Pod Autoscaler (VPA) complète l’HPA en ajustant les ressources allouées à chaque conteneur plutôt que leur nombre. Cette approche s’avère particulièrement pertinente pour les services stateful ou ceux nécessitant une grande quantité de mémoire. Le Cluster Autoscaler opère à un niveau supérieur en ajoutant ou supprimant des nœuds au cluster Kubernetes lui-même lorsque les ressources deviennent insuffisantes ou excessives. Cette stratégie multi-niveaux garantit l’utilisation optimale de l’infrastructure tout en maintenant la performance et la disponibilité. Les fournisseurs cloud comme Exoscale (suisse) ou Infomaniak (suisse) proposent des clusters Kubernetes managés facilitant cette orchestration sans nécessiter d’expertise approfondie en administration système.

Patterns de résilience et tolérance aux pannes

Le pattern Circuit Breaker constitue une protection essentielle contre les pannes en cascade dans une architecture distribuée. Inspiré des disjoncteurs électriques, ce mécanisme surveille les appels vers un service distant et coupe automatiquement la communication lorsque le taux d’échec dépasse un seuil défini. Pendant cette période d’ouverture, les requêtes échouent immédiatement sans solliciter le service défaillant, évitant ainsi l’accumulation de threads bloqués et préservant les ressources. Après un délai configurable, le circuit passe en état semi-ouvert pour tester si le service a récupéré, rétablissant progressivement le trafic normal en cas de succès. Pour une application bancaire intégrant des services tiers de vérification d’identité, ce pattern empêche qu’une défaillance temporaire de ce fournisseur ne bloque l’ensemble de l’application.

La stratégie de bulkhead (compartimentage) isole les ressources allouées à différents services ou fonctionnalités pour limiter l’impact des défaillances. À l’image des compartiments étanches d’un navire empêchant le naufrage complet en cas de voie d’eau, cette approche alloue des pools de threads, connexions et ressources dédiés à chaque service critique. Si un service consomme toutes ses ressources suite à un problème de performance, les autres services continuent de fonctionner normalement avec leurs ressources préservées. Les applications d’assurance suisses implémentent souvent ce pattern en séparant les ressources des services orientés client (consultation de contrats, demandes de devis) de celles des services internes (calculs actuariels, batch nocturnes), garantissant que les traitements lourds n’impactent jamais la réactivité perçue par les utilisateurs.

Le pattern de retry avec backoff exponentiel et jitter améliore la robustesse face aux erreurs transitoires fréquentes dans les environnements distribués. Plutôt que d’abandonner immédiatement lors d’un échec, le système réessaie automatiquement avec des délais croissants entre chaque tentative (1s, 2s, 4s, 8s…). L’ajout de jitter (variation aléatoire) évite le phénomène de thundering herd où des milliers de clients réessaient simultanément, aggravant la charge sur le service en difficulté. Les bibliothèques comme Resilience4j (Java) ou Polly (.NET) implémentent ces patterns de manière déclarative, simplifiant leur adoption. La définition de timeouts appropriés à chaque niveau de la chaîne d’appel complète cette stratégie, garantissant qu’une requête n’attende pas indéfiniment une réponse qui n’arrivera jamais.

Stratégies de caching et optimisation de performance

Le caching distribué constitue un levier majeur d’optimisation de performance pour les applications mobiles d’entreprise. Redis et Memcached dominent ce segment, offrant des capacités de stockage clé-valeur en mémoire avec des temps d’accès inférieurs à la milliseconde. Redis se distingue par ses structures de données avancées (listes, sets, sorted sets, hashes) et ses fonctionnalités de persistance optionnelle, le rendant adapté aussi bien au caching qu’au stockage de sessions ou de files de messages. Pour une application de trading, Redis peut maintenir en cache les cours actualisés et les positions des utilisateurs, évitant des milliers de requêtes par seconde vers la base de données transactionnelle tout en garantissant une latence minimale.

Les stratégies d’invalidation de cache déterminent la fraîcheur des données et représentent un équilibre délicat entre performance et cohérence. L’approche Time-To-Live (TTL) définit une durée de validité au-delà de laquelle les données sont automatiquement supprimées du cache, forçant leur rechargement depuis la source. Cette méthode simple convient aux données dont la fréquence de mise à jour est prévisible. L’invalidation événementielle réagit aux modifications en temps réel : lorsqu’un service met à jour une donnée, il publie un événement entraînant l’invalidation des entrées de cache correspondantes dans tous les services concernés. Les applications financières suisses combinent souvent ces approches, utilisant des TTL courts pour les données réglementaires critiques et l’invalidation événementielle pour les données utilisateur.

Le pattern Cache-Aside (Lazy Loading) optimise l’utilisation du cache en ne chargeant que les données effectivement demandées. Lors d’une requête, l’application vérifie d’abord le cache ; en cas d’absence (cache miss), elle interroge la base de données, stocke le résultat en cache pour les requêtes suivantes, puis retourne la réponse. Cette approche évite de pré-charger des données jamais consultées, maximisant l’efficacité de la mémoire cache limitée. Les solutions de caching multicouche combinent un cache local (dans le processus de l’application) pour les données fréquemment accédées et un cache distribué partagé pour les données communes à toutes les instances. Cette architecture réduit la latence réseau tout en maintenant la cohérence entre instances, crucial pour les applications multi-tenant servant des milliers d’entreprises clientes simultanément.

Sécurité et conformité aux standards bancaires suisses

Application des standards FINMA et protection des données

La FINMA (Autorité fédérale de surveillance des marchés financiers) impose des exigences strictes en matière de sécurité des systèmes d’information pour toutes les institutions financières suisses. Les circulaires FINMA 2008/21 sur l’externalisation et FINMA 2018/3 sur les risques opérationnels et la résilience définissent les standards applicables aux architectures techniques. Ces régulations exigent la mise en œuvre de contrôles de sécurité à tous les niveaux : chiffrement des données en transit et au repos, gestion rigoureuse des accès avec principe du moindre privilège, traçabilité exhaustive des opérations, et plans de continuité d’activité testés régulièrement. Les architectures microservices facilitent le respect de ces exigences en permettant d’appliquer des contrôles granulaires adaptés à la criticité de chaque service.

Le chiffrement de bout en bout constitue une exigence fondamentale pour les applications manipulant des données financières sensibles. L’utilisation de TLS 1.3 pour toutes les communications réseau garantit la confidentialité et l’intégrité des échanges contre les interceptions. Au niveau stockage, le chiffrement transparent des bases de données (TDE – Transparent Data Encryption) protège les données au repos contre les accès non autorisés aux fichiers physiques. Pour les données particulièrement sensibles comme les numéros de compte ou les données personnelles, le chiffrement au niveau application avec gestion des clés via des HSM (Hardware Security Modules) certifiés FIPS 140-2 niveau 3 offre une protection maximale. Les solutions comme HashiCorp Vault facilitent la gestion centralisée des secrets et des clés de chiffrement avec rotation automatique et audit complet.

La Loi fédérale sur la protection des données (LPD) révisée et le RGPD européen imposent des obligations strictes concernant le traitement des données personnelles. Les architectures microservices doivent implémenter des mécanismes de pseudonymisation et d’anonymisation permettant de traiter les données sans exposer l’identité des personnes. Le principe de privacy by design nécessite de minimiser les données collectées et de limiter leur accès au strict nécessaire pour chaque service. La capacité à localiser toutes les données d’un utilisateur spécifique et à les supprimer définitivement (droit à l’oubli) représente un défi architectural résolu par la mise en œuvre d’identifiants corrélés et de mécanismes de propagation des suppressions à travers tous les services. Les entreprises suisses doivent également garantir que les données restent sur le territoire national ou dans des juridictions offrant une protection équivalente, orientant souvent vers des fournisseurs cloud suisses comme Exoscale ou Infomaniak.

Architectures d’authentification et contrôle d’accès

L’authentification multi-facteur (MFA) s’impose comme standard minimal pour sécuriser l’accès aux applications financières mobiles. Cette approche combine plusieurs facteurs de vérification : quelque chose que l’utilisateur connaît (mot de passe), possède (téléphone mobile, token hardware) ou est (biométrie). Les applications bancaires suisses implémentent généralement une authentification primaire par identifiant/mot de passe suivie d’une validation par code SMS, notification push ou lecture biométrique. Les solutions open source comme Keycloak offrent des capacités complètes d’Identity and Access Management avec support natif de MFA, OAuth2, OpenID Connect et SAML. L’intégration avec les systèmes d’identité fédérée permet aux grandes organisations de centraliser la gestion des utilisateurs tout en supportant l’authentification unique (SSO) à travers leurs multiples applications.

Le modèle Zero Trust (confiance zéro) redéfinit la sécurité périmétrique traditionnelle en considérant que toute requête, même interne, doit être authentifiée et autorisée. Dans une architecture microservices, chaque service vérifie l’identité et les permissions du demandeur sans présumer qu’une requête provenant du réseau interne est légitime. L’utilisation de JWT (JSON Web Tokens) signés cryptographiquement permet de transporter les informations d’identité et d’autorisation de manière décentralisée, chaque service validant le token sans consulter un serveur central. Les tokens à courte durée de vie (15-30 minutes) combinés avec des refresh tokens sécurisés limitent la fenêtre d’exposition en cas de compromission. Le service mesh complète cette architecture en vérifiant automatiquement les certificats mTLS de chaque service appelant.

Les politiques d’autorisation fine-grained implémentent le contrôle d’accès basé sur les attributs (ABAC) plutôt que sur les rôles simples (RBAC). Cette approche évalue dynamiquement les permissions en fonction de multiples contextes : identité de l’utilisateur, ressource demandée, action tentée, localisation géographique, niveau de risque de la transaction. Pour une application d’assurance, un conseiller peut consulter les contrats de ses propres clients mais pas ceux d’autres conseillers, sauf s’il possède un mandat de remplacement temporaire et accède depuis le réseau de l’entreprise. Les solutions comme Open Policy Agent (OPA) permettent de définir ces règles complexes dans un langage déclaratif (Rego) centralisé, facilitant leur maintenance et leur audit. L’intégration avec le service mesh automatise l’application de ces politiques à chaque communication inter-services.

Traçabilité et audit pour la conformité réglementaire

La traçabilité exhaustive des opérations constitue une obligation légale pour les institutions financières suisses, devant conserver des logs détaillés de toutes les transactions pendant des durées pouvant atteindre 10 ans. L’architecture de logging centralisée agrège les journaux de tous les microservices dans une plateforme unifiée permettant recherche, analyse et archivage à long terme. La stack ELK (Elasticsearch, Logstash, Kibana) domine ce segment open source, Elasticsearch stockant et indexant les logs, Logstash assurant leur collecte et transformation, et Kibana fournissant les interfaces de visualisation et recherche. Pour les environnements Kubernetes, Fluentd ou Fluent Bit s’intègrent nativement pour collecter automatiquement les logs de tous les conteneurs et les transmettre vers le système centralisé.

La corrélation des événements à travers les services distribués nécessite l’utilisation d’identifiants de corrélation propagés dans toutes les requêtes. Lorsqu’une transaction métier traverse plusieurs microservices, un UUID unique généré au point d’entrée accompagne chaque appel, permettant de reconstituer a posteriori la chaîne complète des opérations. Cette capacité s’avère cruciale lors d’investigations sur des transactions suspectes ou pour répondre aux demandes réglementaires nécessitant la traçabilité complète d’une opération spécifique. L’enrichissement automatique des logs avec des métadonnées contextuelles (identité utilisateur, session, service appelé, résultat) facilite les analyses ultérieures et la détection d’anomalies par corrélation de patterns inhabituels.

Les solutions SIEM (Security Information and Event Management) agrègent les événements de sécurité provenant de toutes les couches de l’infrastructure pour détecter les menaces en temps réel. Ces systèmes analysent les logs d’authentification, les tentatives d’accès refusées, les modifications de configuration, les patterns de trafic réseau anormaux, et corrèlent ces événements pour identifier les attaques sophistiquées. Des règles de détection identifient les indicateurs de compromission comme des tentatives de connexion répétées depuis des localisations géographiques incohérentes, des accès à des volumes inhabituels de données, ou des séquences d’opérations caractéristiques d’une reconnaissance système. Pour les entreprises suisses, des solutions open source comme Wazuh offrent des capacités SIEM complètes avec modules spécialisés pour la conformité PCI-DSS et la détection d’intrusion, à un coût nettement inférieur aux solutions propriétaires commerciales.

Multi-tenancy et intégration des systèmes legacy

Architectures multi-tenant pour applications SaaS

Les applications multi-tenant servent de multiples clients (tenants) à partir d’une infrastructure partagée, optimisant les coûts tout en maintenant l’isolation des données. Trois approches architecturales coexistent avec des compromis différents entre isolation, coûts et complexité. Le modèle base de données partagée avec discrimination par tenant_id stocke les données de tous les clients dans les mêmes tables, une colonne identifiant le propriétaire de chaque enregistrement. Cette approche maximise la mutualisation mais nécessite une vigilance extrême pour éviter les fuites de données entre tenants. Le modèle schéma séparé alloue un schéma de base de données distinct à chaque tenant dans une même instance, offrant un meilleur compromis isolation/coût. Le modèle base de données dédiée par tenant garantit l’isolation maximale au prix d’une complexité opérationnelle et de coûts supérieurs.

La personnalisation par tenant représente un défi architectural majeur pour les applications SaaS d’entreprise. Les grands clients suisses exigent souvent des adaptations spécifiques : logos et branding personnalisés, workflows métier ajustés, intégrations avec leurs systèmes internes. L’architecture microservices facilite cette personnalisation en permettant de déployer des versions spécifiques de certains services pour les tenants premium, tout en partageant les services communs. Le pattern de configuration externalisée via des bases de données de paramétrage ou des systèmes comme Consul permet d’adapter le comportement applicatif sans redéploiement. Pour les personnalisations complexes, le pattern Sidecar permet d’injecter du code spécifique au tenant sous forme de plugins chargés dynamiquement, préservant le cœur applicatif commun.

La performance et l’équité entre tenants nécessitent des mécanismes de resource quotas et de rate limiting différenciés. Les tenants premium disposant d’offres supérieures bénéficient de quotas plus élevés et de priorités d’exécution favorables. Kubernetes supporte nativement les ResourceQuotas limitant les ressources CPU, mémoire et stockage consommables par namespace, chaque tenant occupant son propre namespace. Au niveau applicatif, les algorithmes de token bucket ou de leaky bucket implémentent un rate limiting sophistiqué permettant des burst temporaires tout en garantissant des limites moyennes. Le monitoring détaillé par tenant révèle les consommations réelles et permet une facturation au usage (pay-per-use) précise, modèle économique privilégié pour les applications SaaS financières.

Stratégies d’intégration avec systèmes mainframe et legacy

Les grandes entreprises et institutions suisses opèrent encore massivement des systèmes mainframe hébergeant leurs données cœur de métier, nécessitant des stratégies d’intégration robustes. Le pattern Strangler Fig permet de moderniser progressivement ces systèmes sans big bang risqué, en dirigeant graduellement le trafic vers de nouveaux microservices qui répliquent puis remplacent les fonctionnalités legacy. Une façade d’intégration (API Gateway) route intelligemment les requêtes soit vers les nouveaux services pour les fonctionnalités migrées, soit vers le système legacy pour celles encore en cours de migration. Cette approche itérative limite les risques tout en permettant de valider chaque étape avant de poursuivre, particulièrement adaptée aux applications critiques ne tolérant aucune interruption de service.

Les Enterprise Service Bus (ESB) traditionnels comme Apache Camel ou MuleSoft facilitent l’intégration en assurant la médiation entre protocoles hétérogènes. Ces plateformes transforment les messages entre formats incompatibles (SOAP, REST, MQ, fichiers plats), orchestrent les workflows complexes impliquant plusieurs systèmes, et garantissent la fiabilité via des mécanismes de retry et de compensation. Pour une banque suisse intégrant un mainframe IBM z/OS avec des applications mobiles modernes, l’ESB expose les programmes COBOL via des API REST consommables par les microservices, masquant la complexité des protocoles propriétaires. La tendance actuelle favorise cependant des approches plus légères avec de simples adaptateurs plutôt que des ESB monolithiques, alignées avec la philosophie microservices.

La synchronisation de données entre systèmes legacy et microservices nécessite des stratégies de Change Data Capture (CDC) capturant les modifications en temps quasi-réel. Des solutions comme Debezium surveillent les logs de transactions des bases de données legacy et publient les changements sous forme d’événements dans Kafka, permettant aux microservices de maintenir leurs propres vues synchronisées. Cette approche événementielle découple les systèmes sans nécessiter de modifications du code legacy, préservant ainsi la stabilité des applications critiques. Pour les données nécessitant une cohérence forte, des patterns de dual-write avec orchestration saga garantissent que les modifications atteignent de manière fiable tous les systèmes concernés ou sont annulées en cas d’échec, maintenant la cohérence métier malgré la distribution.

Méthodologie de migration progressive vers microservices

La migration d’une architecture monolithique vers des microservices représente un projet pluriannuel nécessitant une planification méticuleuse. La première phase consiste à identifier les bounded contexts métier et à cartographier les dépendances existantes pour définir une stratégie de découpage cohérente. L’analyse du code legacy révèle les modules à fort couplage nécessitant un refactoring préalable, et identifie les fonctionnalités candidates pour une extraction prioritaire. Les services offrant le meilleur retour sur investissement combinent généralement haute valeur métier, besoin de scalabilité indépendante, et faible couplage avec le reste du système. Pour une compagnie d’assurance, le service de calcul de primes constitue souvent un candidat idéal : logique métier complexe, utilisé intensivement, et relativement indépendant.

La stratégie de migration big bang refondant l’intégralité du système présente des risques prohibitifs pour les applications critiques. L’approche incrémentale privilégie l’extraction progressive de services, validant chaque étape avant de poursuivre. Le pattern Anti-Corruption Layer protège les nouveaux microservices de la complexité du legacy en créant une couche d’abstraction traduisant entre les modèles de données. Cette barrière préserve la pureté architecturale des nouveaux services tout en maintenant l’interopérabilité avec le legacy durant la transition. Les feature flags permettent d’activer progressivement les nouvelles implémentations microservices pour un sous-ensemble d’utilisateurs, détectant les problèmes avant généralisation tout en conservant la possibilité de rollback instantané.

La gestion du changement organisationnel accompagne nécessairement la transformation technique vers les microservices. La transition d’équipes organisées par couches techniques (frontend, backend, database) vers des équipes produit autonomes responsables de microservices complets nécessite un accompagnement culturel. La formation aux nouvelles technologies (Kubernetes, service mesh, observabilité distribuée) et aux méthodologies DevOps s’avère indispensable pour que les équipes maîtrisent l’ensemble du cycle de vie de leurs services. L’adoption de pratiques d’infrastructure as code avec Terraform ou Ansible garantit la reproductibilité des environnements et réduit les écarts entre développement et production. Les entreprises suisses sous-estiment souvent cette dimension humaine, source majeure d’échec des projets de modernisation technique pourtant bien conçus sur le plan architectural.

Conclusion : bâtir des applications mobiles d’entreprise résilientes et sécurisées

L’architecture microservices s’impose comme la réponse technique adaptée aux exigences complexes des applications mobiles d’entreprise suisses opérant dans des secteurs hautement réglementés. La décomposition en services autonomes offre l’agilité nécessaire pour innover rapidement tout en maintenant la stabilité des composants critiques. L’orchestration via Kubernetes automatise la gestion de l’infrastructure, tandis que le service mesh sécurise et optimise les communications entre services. Cette sophistication technique permet de gérer des pics de charge importants, d’assurer une disponibilité maximale et de répondre aux standards de sécurité bancaire parmi les plus exigeants au monde. Les entreprises maîtrisant cette architecture bénéficient d’avantages concurrentiels décisifs en termes de time-to-market, d’expérience utilisateur et de maîtrise des coûts opérationnels.

Le respect des contraintes réglementaires suisses, incluant les circulaires FINMA et la protection des données personnelles, s’intègre naturellement dans une architecture microservices bien conçue. La granularité des services permet d’appliquer des contrôles de sécurité proportionnés à la criticité de chaque composant, tandis que la traçabilité exhaustive facilite les audits de conformité. L’utilisation de solutions open source matures comme Kubernetes, Istio, Prometheus et Keycloak réduit significativement les coûts de licences tout en offrant une flexibilité et une pérennité supérieures aux solutions propriétaires. La préférence pour des fournisseurs d’infrastructure suisses garantit la souveraineté des données et facilite la conformité avec les exigences de localisation.

La migration progressive depuis des architectures monolithiques ou l’intégration avec des systèmes legacy mainframe constituent des défis maîtrisables grâce à des patterns éprouvés comme Strangler Fig et Anti-Corruption Layer. Ces approches incrémentales limitent les risques tout en permettant une transformation continue alignée sur les capacités d’absorption de l’organisation. L’accompagnement du changement organisationnel et culturel s’avère aussi crucial que l’excellence technique, les équipes devant acquérir de nouvelles compétences et adopter une mentalité DevOps de responsabilité end-to-end. Les entreprises suisses investissant dans cette double transformation technique et humaine positionnent durablement leur capacité d’innovation digitale face à une concurrence internationale toujours plus agile.

Questions fréquentes

Quelle est la différence principale entre une architecture monolithique et une architecture microservices ?

Une architecture monolithique concentre toutes les fonctionnalités dans une application unique partageant une base de code commune et déployée comme un tout indivisible. En revanche, l’architecture microservices décompose l’application en services indépendants, chacun gérant une capacité métier spécifique avec sa propre base de données et pouvant être développé, déployé et mis à l’échelle indépendamment. Cette séparation offre une agilité supérieure et une meilleure résilience, puisqu’une panne dans un service n’affecte pas les autres, contrairement au monolithe où une défaillance peut compromettre l’ensemble du système. Pour les applications mobiles d’entreprise suisses nécessitant évolutivité et haute disponibilité, les microservices constituent généralement l’approche la plus adaptée malgré une complexité opérationnelle accrue.

Pourquoi utiliser un API Gateway dans une architecture microservices ?

L’API Gateway sert de point d’entrée unique pour toutes les requêtes clients vers l’infrastructure microservices, masquant la complexité de l’architecture distribuée. Il assure des fonctions essentielles comme le routage intelligent vers les services appropriés, l’agrégation de réponses provenant de multiples services, l’authentification et l’autorisation centralisées, le rate limiting pour protéger contre les abus, et la transformation de protocoles. Pour les applications mobiles, l’API Gateway optimise également les échanges réseau en regroupant plusieurs appels backend en une seule requête depuis le mobile, réduisant ainsi la latence et la consommation de batterie. Cette couche simplifie également l’évolution de l’architecture backend sans impacter les clients mobiles déjà déployés, en maintenant des contrats d’API stables même lorsque les services internes changent.

Comment garantir la sécurité des communications entre microservices ?

La sécurité inter-services repose sur plusieurs couches de protection complémentaires. Le chiffrement mTLS (mutual TLS) authentifie mutuellement les services communicants et chiffre les échanges, empêchant interceptions et usurpations d’identité. Un service mesh comme Istio automatise le déploiement de ces protections sans modifier le code applicatif. Les politiques d’autorisation fine définissent précisément quels services peuvent communiquer entre eux, appliquant le principe du moindre privilège. L’utilisation de tokens JWT signés cryptographiquement permet de propager l’identité de l’utilisateur initial à travers la chaîne d’appels, chaque service validant les permissions avant traitement. Enfin, la segmentation réseau via network policies Kubernetes isole les services par niveau de sensibilité, garantissant qu’un service compromis ne peut accéder qu’à un périmètre limité du système.

Qu’est-ce que le pattern Circuit Breaker et pourquoi est-il important ?

Le Circuit Breaker protège une architecture distribuée contre les pannes en cascade en surveillant les appels vers les services distants et en coupant automatiquement la communication lorsque le taux d’échec dépasse un seuil défini. Pendant cette période d’ouverture, les requêtes échouent immédiatement sans solliciter le service défaillant, évitant l’accumulation de threads bloqués et préservant les ressources pour les services fonctionnels. Après un délai configurable, le circuit teste si le service a récupéré avant de rétablir progressivement le trafic. Ce pattern s’avère crucial pour les applications financières suisses où la disponibilité doit rester maximale même en cas de défaillance partielle. Il permet également d’implémenter des comportements de dégradation gracieuse, par exemple en retournant des données en cache plutôt qu’en bloquant complètement une fonctionnalité lorsqu’un service secondaire est indisponible.

Comment gérer la cohérence des données dans une architecture microservices ?

La cohérence des données représente l’un des défis majeurs des architectures distribuées. Contrairement aux monolithes utilisant des transactions ACID classiques, les microservices privilégient généralement la cohérence éventuelle, acceptant qu’une modification prenne quelques instants pour se propager. Le pattern Saga orchestre les transactions distribuées en décomposant l’opération métier en une séquence d’actions locales, chacune suivie d’un événement déclenchant l’étape suivante. En cas d’échec, des transactions compensatoires annulent les modifications précédentes. Cette approche nécessite une conception métier soigneuse pour identifier les opérations tolérant la latence de propagation. Pour les cas exigeant une cohérence forte, les fonctionnalités concernées peuvent être regroupées au sein d’un même service partageant une base de données commune. L’event sourcing offre une alternative élégante en persistant l’intégralité des événements plutôt que l’état actuel, facilitant la reconstruction cohérente de l’état à tout moment.

Quels sont les avantages de Kubernetes pour les applications microservices ?

Kubernetes automatise le déploiement, la mise à l’échelle et l’exploitation de conteneurs applicatifs sur un cluster de machines. Son approche déclarative permet aux équipes de définir l’état souhaité de leur application, Kubernetes travaillant continuellement pour maintenir cet état. L’autoscaling horizontal ajuste automatiquement le nombre d’instances selon la charge, tandis que l’autoscaling vertical optimise les ressources allouées. Les mécanismes de self-healing redémarrent automatiquement les conteneurs défaillants et redistribuent les charges. Le service discovery intégré permet aux services de se localiser mutuellement sans configuration statique, facilitant le déploiement dynamique. Les rolling updates déploient progressivement les nouvelles versions sans interruption de service, avec rollback automatique en cas de problème. Pour les entreprises suisses, Kubernetes offre également la portabilité entre fournisseurs cloud, évitant le vendor lock-in tout en standardisant les pratiques opérationnelles.

Comment implémenter le multi-tenancy dans une application microservices ?

Le multi-tenancy peut s’implémenter selon trois approches principales offrant des compromis différents. Le modèle base de données partagée avec discrimination par tenant_id maximise la mutualisation en stockant les données de tous les clients dans les mêmes tables, une colonne identifiant le propriétaire. Cette approche optimise les coûts mais nécessite une vigilance extrême contre les fuites de données. Le modèle schéma séparé alloue un schéma distinct à chaque tenant dans une même instance de base de données, offrant un meilleur équilibre isolation/coût. Le modèle base de données dédiée garantit l’isolation maximale au prix d’une complexité opérationnelle supérieure. Au niveau applicatif, l’utilisation de namespaces Kubernetes distincts par tenant permet d’appliquer des quotas de ressources et des politiques de sécurité différenciées. L’identification du tenant s’effectue généralement via un sous-domaine dédié ou un header HTTP, propagé ensuite dans tous les appels inter-services pour maintenir le contexte.

Quelles solutions de monitoring recommandez-vous pour une architecture microservices ?

L’observabilité d’une architecture distribuée nécessite la combinaison de plusieurs outils complémentaires couvrant métriques, logs et traces. Prometheus collecte et stocke les métriques en séries temporelles avec un système d’alerting puissant, tandis que Grafana visualise ces données dans des tableaux de bord personnalisables. La stack ELK (Elasticsearch, Logstash, Kibana) centralise et indexe les logs de tous les services, facilitant les recherches et analyses. Jaeger ou Zipkin tracent le parcours des requêtes à travers les services, révélant les goulots d’étranglement de performance. L’intégration d’un service mesh comme Istio automatise la collecte de ces métriques sans instrumentation manuelle du code. Pour les applications financières suisses, l’ajout d’un SIEM comme Wazuh corrèle les événements de sécurité et détecte les menaces en temps réel. Ces solutions open source offrent des capacités enterprise sans les coûts prohibitifs des outils propriétaires commerciaux.

Comment migrer progressivement d’une architecture monolithique vers des microservices ?

La migration progressive évite les risques d’un big bang en extrayant graduellement des services du monolithe. Le pattern Strangler Fig place une façade d’intégration devant le système legacy, routant intelligemment le trafic vers les nouveaux microservices pour les fonctionnalités migrées et vers le legacy pour le reste. Cette approche permet de valider chaque étape avant de poursuivre. Commencez par identifier les bounded contexts métier et priorisez l’extraction des services offrant le meilleur retour sur investissement : forte valeur métier, besoin de scalabilité indépendante, faible couplage. L’Anti-Corruption Layer protège les nouveaux services de la complexité du legacy en traduisant entre les modèles de données. Les feature flags permettent d’activer progressivement les nouvelles implémentations pour un sous-ensemble d’utilisateurs avec possibilité de rollback instantané. Cette transformation technique doit s’accompagner d’un changement organisationnel vers des équipes produit autonomes et d’une montée en compétences sur les technologies cloud-native.

Quelles sont les exigences spécifiques de la FINMA pour les architectures IT bancaires ?

La FINMA impose des exigences strictes via ses circulaires, notamment la 2008/21 sur l’externalisation et la 2018/3 sur les risques opérationnels. Les architectures doivent implémenter le chiffrement des données en transit et au repos, la gestion rigoureuse des accès avec principe du moindre privilège, la traçabilité exhaustive des opérations avec conservation longue durée, et des plans de continuité d’activité testés régulièrement. La ségrégation des environnements (développement, test, production) doit être strictement appliquée, avec des contrôles d’accès empêchant les modifications directes en production. Les changements doivent suivre un processus formalisé avec validation, tests et approbation avant déploiement. La sous-traitance à des fournisseurs cloud nécessite des contrats garantissant la conformité réglementaire, l’auditabilité et la localisation des données en Suisse ou juridiction équivalente. Les architectures microservices facilitent ces exigences en permettant d’appliquer des contrôles granulaires adaptés à chaque service selon sa criticité.

0 commentaires